openEuler 安装 hive4

准备

HDFS配置

vim $HADOOP_HOME/etc/hadoop/core-site.xml

<!--配置所有节点的root用户都可作为代理用户-->

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<!--配置root用户能够代理的用户组为任意组-->

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

<!--配置root用户能够代理的用户为任意用户-->

<property>

<name>hadoop.proxyuser.root.users</name>

<value>*</value>

</property>

启动Hadoop

# 启动hadoop

start-all.sh

# 检查hadoop进程

jps

# 检查各端口

netstat -aplnt | grep java

检查MySQL是否启动成功

ps -aux | grep mysql

netstat -aplnt | grep 3306

安装hive

# 将软件上传到 /opt/soft 目录

# 解压hive

tar -zxvf apache-hive-4.0.0-bin.tar.gz

# 目录改名

mv apache-hive-4.0.0-bin hive-3

# 进入配置文件目录

cd /opt/soft/hive-4/conf

# 复制配置文件

cp hive-env.sh.template hive-env.sh

cp hive-default.xml.template hive-site.xml

# 编辑环境配置文件

vim hive-env.sh

# 编辑配置文件

vim hive-site.xml

hive-env.sh

# hadoop 安装路径

export HADOOP_HOME=/opt/soft/hadoop-3/

# hive 配置文件路径

export HIVE_CONF_DIR=/opt/soft/hive-4/conf/

hive-site.xml

需要修改的位置提炼如下:

<configuration>

<!-- 记录HIve中的元数据信息 记录在mysql中 -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://spark03:3306/hive?allowPublicKeyRetrieval=true&useUnicode=true&createDatabaseIfNotExist=true&characterEncoding=UTF8&useSSL=false&useServerPrepStmts=false&rewriteBatchedStatements=true&cachePrepStmts=true&allowMultiQueries=true&serverTimeZone=Asia/Shanghai&sslMode=DISABLED</value>

</property>

<!-- jdbc mysql驱动 -->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.cj.jdbc.Driver</value>

</property>

<!-- mysql的用户名和密码 -->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>Lihaozhe!!@@1122</value>

</property>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<property>

<name>hive.exec.scratchdir</name>

<value>/user/hive/tmp</value>

</property>

</property>

<property>

<name>hive.exec.local.scratchdir</name>

<value>/user/hive/local</value>

<description>Local scratch space for Hive jobs</description>

</property>

<property>

<name>hive.downloaded.resources.dir</name>

<value>/user/hive/resources</value>

<description>Temporary local directory for added resources in the remote file system.</description>

</property>

<!-- 日志目录 -->

<property>

<name>hive.querylog.location</name>

<value>/user/hive/log</value>

</property>

<!-- 设置metastore的节点信息 -->

<property>

<name>hive.metastore.uris</name>

<value>thrift://spark01:9083</value>

</property>

<!-- 客户端远程连接的端口 -->

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

</property>

<property>

<name>hive.server2.thrift.bind.host</name>

<value>0.0.0.0</value>

</property>

<property>

<name>hive.server2.webui.host</name>

<value>0.0.0.0</value>

</property>

<!-- hive服务的页面的端口 -->

<property>

<name>hive.server2.webui.port</name>

<value>10002</value>

</property>

<property>

<name>hive.server2.long.polling.timeout</name>

<value>5000ms</value>

</property>

<property>

<name>hive.server2.enable.doAs</name>

<value>true</value>

</property>

<!--

<property>

<name>datanucleus.autoCreateSchema</name>

<value>false</value>

</property>

<property>

<name>datanucleus.fixedDatastore</name>

<value>true</value>

</property>

-->

<property>

<name>hive.execution.engine</name>

<value>mr</value>

</property>

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

<property>

<name>hive.server2.logging.operation.log.location</name>

<value>/home/hive/tmp/operation_logs</value>

</property>

</configuration>

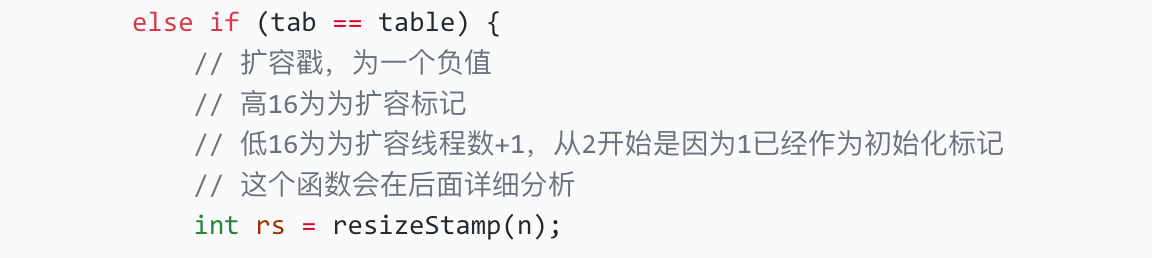

注意:上面配置文件中的路径在 vi 编辑器下 全局替换

:%s@\${system:java.io.tmpdir}@/tmp/hive-log@g不要使用图形化 不然每次保存后3215行都会有个  特殊字符 如果产生删除即可 具体报错信息 后面有单独的描述

上传 MySQL 连接驱动 jar 包到 hive 安装目录的lib目录下:

$HIVE_HOME/lib

删除原有的 protobuf-java-3.24.4.jar 文件

jar 包有两个 分别为:

- mysql-connector-j-8.4.0.jar

- protobuf-java-4.27.1.jar

guava版本冲突

删除 hive/lib目录中的 guava-22.0.jar

拷贝hadoop/share/hadoop/common/lib目录中的 guava-27.0-jre.jar 到 hive/lib 目录

rm -f $HIVE_HOME/lib/guava-22.0.jar

cp -v $HADOOP_HOME/share/hadoop/common/lib/guava-27.0-jre.jar $HIVE_HOME/lib

配置环境变量

vim /etc/profile.d/my_env.sh

export HIVE_HOME=/opt/soft/hive-3

export HCATALOG_HOME=/opt/soft/hive-3/hcatalog

export PATH=$PATH:$HIVE_HOME/bin:$HCATALOG_HOME/bin:$HCATALOG_HOME/sbin

source /etc/profile

初始化hive的元数据库

注意:初始初始元数据库之前 保证 hadoop 和 mysql 正常启动

schematool -initSchema -dbType mysql -verbose

报错解解决:

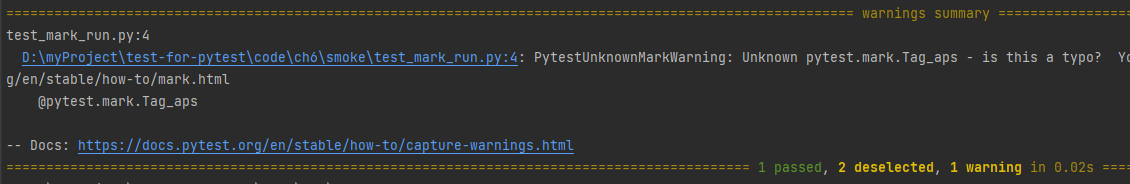

Exception in thread "main" java.lang.RuntimeException: com.ctc.wstx.exc.WstxParsingException: Illegal character entity: expansion character (code 0x8

at [row,col,system-id]: [3215,96,"file:/usr/local/hive/conf/hive-site.xml"]

at org.apache.hadoop.conf.Configuration.loadResource(Configuration.java:3051)

...

at org.apache.hadoop.util.RunJar.main(RunJar.java:236)

Caused by: com.ctc.wstx.exc.WstxParsingException: Illegal character entity: expansion character (code 0x8

at [row,col,system-id]: [3215,96,"file:/usr/local/hive/conf/hive-site.xml"]

at com.ctc.wstx.sr.StreamScanner.constructWfcException(StreamScanner.java:621)

...

at org.apache.hadoop.conf.Configuration.loadResource(Configuration.java:3034)

... 17 more

报错原因:

hive-site.xml配置文件中,3215行(见报错记录第二行)有特殊字符

解决办法:

进入hive-site.xml文件,跳转到对应行,删除里面的  特殊字符即可

Caused by: java.net.URISyntaxException: Relative path in absolute URI: ${system:java.io.tmpdir%7D/$%7Bsystem:user.name%7D

at java.net.URI.checkPath(URI.java:1822)

at java.net.URI.<init>(URI.java:745)

at org.apache.hadoop.fs.Path.initialize(Path.java:260)

解决方案:将hive-site.xml配置文件的

hive.querylog.location

hive.exec.local.scratchdir

hive.downloaded.resources.dir

三个值(原始为$标识的相对路径)写成绝对值

# 全局替换

:%s@\${system:java.io.tmpdir}@/tmp/hive-log@g

中文乱码

alter table COLUMNS_V2 modify column COMMENT varchar(256) character set utf8;

alter table TABLE_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

alter table PARTITION_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

alter table PARTITION_KEYS modify column PKEY_COMMENT varchar(4000) character set utf8;

alter table INDEX_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

flush privileges;

log日志冲突

不推荐删除 除非感觉日志

rm -f /opt/soft/hadoop-3/share/hadoop/common/lib/slf4j-api-1.7.36.jar

rm -f /opt/soft/hadoop-3/share/hadoop/common/lib/slf4j-reload4j-1.7.36.jar

rm -f /opt/soft/hadoop-3/share/hadoop/common/lib/jul-to-slf4j-1.7.36.jar

rm -f /opt/soft/hive-4/lib/log4j-slf4j-impl-2.18.0.jar

rm -f /opt/soft/hive-4/hcatalog/share/webhcat/svr/lib/jul-to-slf4j-1.7.30.jar

分发软件和环境变量

scp -r /opt/soft/hive-4 root@spark02:/opt/soft/

scp -r /opt/soft/hive-4 root@spark03:/opt/soft/

scp /etc/profile.d/my_env.sh root@spark02:/etc/profile.d/

scp /etc/profile.d/my_env.sh root@spark03:/etc/profile.d/

在各节点使新的环境变量生效

source /etc/profile

远程模式

# 启动服务端

hive --service metastore

hive --service hiveserver2

# 启动服务端 后台运行

hive --service metastore &

hive --service hiveserver2 &

# 启动服务端 后台运行

nohup hive --service metastore > /dev/null 2>&1 &

nohup hive --service hiveserver2 > /dev/null 2>&1 &

hiveserver2 start

nohup hiveserver2 start >/dev/null 2>&1 &

bash 中 0、1、2 三个数字分别代表 STDIN_FILENO 、 STDOUT_FILENO 、STDERR_FILENO ,

即标准输入(一般是键盘),

标准输出(一般是显示屏,准确的说是用户终端控制台),

标准错误(输出错信息输出)。

| 数字 | 含义 |

|---|---|

| 0 | 标准输入(一般是键盘) |

| 1 | 标准输出(一般是显示屏,准确的说是用户终端控制台) |

| 2 | 标准错误(输出错信息输出) |

/dev/null看作"黑洞". 它等价于一个只写文件.

所有写入它的内容都会永远丢失.

而尝试从它那儿读取内容则什么也读不到

# 客户端连接

hive

beeline -u jdbc:hive2://spark01:10000 -n root

beeline jdbc:hive2://spark01:10000> show databases;

体验

use default;

create table person (

id int,

phonenum bigint,

salary dicimal,

name string

);

show tables;

insert into person values (1001,13966668888,9999.99,"张三");

![[A133]全志u-boot中的I2C驱动分析](https://img-blog.csdnimg.cn/direct/eb19ee41b3da47fbb1fc1c65b8842719.png)